Когда для сбора нужной информации стоит задача разложить сложную структуру сайта на составные элементы - на помощь приходит парсинг. Для качественного парсинга необходимо понять, что такое веб краулинг и что такое веб скрапинг.

Для начала дадим определения этим терминам и разберемся, как работает веб краулинг и веб скрапинг:

Веб-краулинг - это автоматический процесс обхода веб страниц, выполняемый ботом (или как его называют иначе, пауком). При веб-краулинге происходит сбор ссылок веб-сайта и на основе этого составляется сеть данных, которая сохраняется для дальнейшего использования и анализа.

Веб-скрапинг - это процесс сбора какой-либо конкретной информации с веб страницы.

Скрапинг и краулинг имеют свои особенности, но цели у них почти идентичные. Давайте для начала рассмотрим основные задачи, для которых служат эти инструменты:

Несмотря на то что оба процесса применяются для похожих целей, каждый из них имеет ряд собственных особенностей. Далее будут приведены основные отличия.

Область применения. Веб-краулинг подразумевает систематический просмотр веб-страниц, переходя по ссылкам с одной страницы на другую. Он охватывает большой объем страниц и направлен на индексацию контента для поисковых систем.

Веб-скрапинг, в свою очередь, более целенаправлен. Он предполагает извлечение определенных данных с конкретных веб-страниц в соответствии с требованиями пользователя.

Частота активности. Краулеры работают непрерывно, чтобы обеспечить актуальность индексов поисковых систем. Они регулярно посещают веб-сайты, чтобы обнаружить новый контент и обновить существующую информацию. Скрапинг может быть одноразовым действием или выполняться периодически, в зависимости от конкретных целей.

Взаимодействие с информацией. Краулеры загружают и индексируют содержимое веб-страниц, но не всегда взаимодействуют с ним. Они занимаются обнаружением и категоризацией данных. Скрапинг предполагает извлечение какой-либо конкретной информации. Он часто требует более глубокого взаимодействия со структурой страницы, например, определения и извлечения данных из определенных элементов HTML.

Веб-скрапинг является удобным инструментом для выборки данных. Этот вид парсинга имеет ряд преимуществ и недостатков. Вот основные из них:

Преимущества:

Недостатки:

При краулинге веб страниц также имеется ряд своих особенностей. Основные плюсы и минусы этого метода представлены далее.

Плюсы веб-краулинга:

Минусы веб-краулинга:

Проблема “глубокой паутины”. Несмотря на все преимущества “веб-паука”, в просторах интернета существуют участки, которые остаются недоступными для него. Фактически лишь 60 процентов веб-страниц доступны для веб-краулинга.

Парсинг сайтов через Python является одним из самых эффективных решений для сбора требуемой информации. Для вашего удобства в статье будет представлен пошаговый туториал по веб скрапингу через Python.

Для написания собственного парсера на Python необходимо выполнить следующие шаги:

Определение условной задачи. Представим ситуацию, что у нас есть интернет-магазин, в котором определенное количество товаров представлено на 10 страницах. Нашей задачей будет собрать с каждого товара информацию о его названии, характеристиках и стоимости.

Установка библиотек: устанавливаем библиотеки следующими командами - pip install requests и pip install beautifulsoup4.

Переходим к написанию кода. Объявим первую функцию, которая будет принимать на вход номер последней страницы, собирать url адреса на карточки товаров и возвращать их:

crawl_products(pages_count):

urls = [ ]

return urls

parse_products(urls):

data = [ ]

return data

def main():

urls = crawl_products(PAGES_COUNT)

data = parse_products(urls)

fmt = ‘https://url сайта/?page={page}’

for page_n in range(1, 1 + pages_count):

page_url = fmt.format(page=page_n)

response = requests.get(page_url)

def get_soup(url, **kwargs):

response = requests.get(url, **kwargs)

if response.status_code = 200;

soup = BeautifulSoup(response.text, features=’html.parser’)

else:

soup = None

return soup

—---------

print(‘page: {}’.format(page_n))

page_url = fmt.format(page=page_n)

soup = get_soup(page_url)

if soup is None:

break

for tag in soup.select(‘.product-card .title’):

href = tag.attrs[‘href’]

url = ‘https://url сайта.format(href)

urls.append(url)

return urls

print(‘\n’.join(urls))

def parse_products(urls):

data = [ ]

for url in urls:

soup = get_soup(url)

if soup is Non:

break

name = soup.select_one(‘#️product_name’).text.strip()

amount = soup.select_one(‘#️product_amount’).text.strip()

techs = {}

for row in soup.select(‘#️characteristics tbody tr’):

cols = row.select(‘td’)

cols = [c.text.strip() for c in cols]

techs[cols[0]] = cols[1]

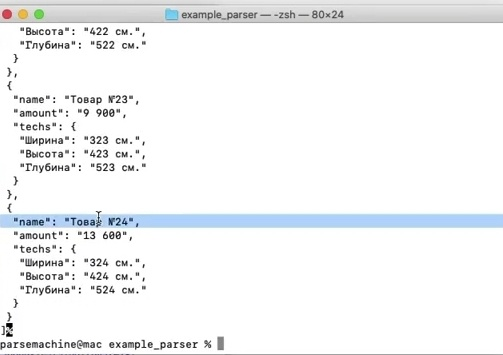

item = {

‘name’: name,

‘amount’: amount,

‘techs’: techs,

)

data.append(item)

with open(OUT_FILENAME, ‘w’) as f:

json.dump(data, f, ensure_ascii=False, indent=1)

Веб скрапинг на Python невозможно представить без использования вспомогательных библиотек. Независимо от того, опытный вы разработчик или новичок, освоение библиотек для парсинга на Python станет хорошим навыком для веб скрапинга. К этим библиотекам относится следующие трио: request, selenium, beautiful soup. Давайте рассмотрим более подробную информацию по каждой библиотеке.

В основе многих проектов по веб-скрепингу лежит библиотека requests. Это надежная HTTP-библиотека для выполнения виртуальных запросов. Благодаря своей простоте и удобству в использовании она отлично подходит для извлечения HTML-контента с веб-страниц. С помощью всего нескольких строк кода вы можете отправлять GET- или POST-запросы и обрабатывать поступающие данные.

Веб скрапинг через библиотеку Selenium на Python является одним из ключевых инструментов, предлагая универсальный фреймворк для автоматического взаимодействия с браузером. Обеспечивая кросс-браузерную совместимость, selenium отлично справляется с такими задачами, как автоматизированное тестирование и исследование веб страниц. Selenium используется для обеспечения функциональности веб-приложений, извлечения данных с веб-сайтов или автоматизации рутинных задач.

Веб-скрапинг с помощью библиотеки beautiful soup предполагает использование Python для извлечения и разбора данных из документов HTML или XML. Используя функции beautiful soup, такие как поиск тегов, навигация по структуре документа и фильтрация содержимого на основе общих признаков, вы можете эффективно извлекать информацию с веб-страниц. Кроме того, beautiful soup может работать в связке с другими библиотеками Python, например, с requests, что делает ее более гибкой в использовании.

Для парсинга в профессиональных целях, например, для сорсинга, потребуются дополнительные сервисы для веб скрапинга. Представленные далее инструменты относятся к разряду топовых и в полной мере помогут упростить и оптимизировать сбор информации, что позволит производить более быстрый поиск кандидатов или совершение любых других задач по анализу данных.

AutoPagerize - это расширение для браузера, призванное значительно расширить возможности скрапинга, автоматизировав зачастую трудоемкий процесс навигации по контенту веб-сайтов. Особенностью AutoPagerize является его способность интеллектуально определять и обрабатывать различные шаблоны данных на большом объёме веб страниц. Благодаря этому пользователи избавлены от необходимости настраивать свои скрипты под каждую уникальную структуру. Это делает AutoPagerize универсальным решением, способным легко приспособиться к различным форматам, используемым на разных сайтах.

Instant Data Scraper - ещё один удобный инструмент, предназначенный для легкого веб-скрапинга. Благодаря интуитивно понятному интерфейсу вы можете легко ориентироваться в процессе сбора данных без применения сложного кодирования или технических знаний. Следует отметить универсальность инструмента, поскольку он поддерживает разные веб-сайты и платформы, позволяя извлекать информацию из различных источников - от социальных сетей до новостных сайтов.

Instant Data Scraper также позволяет извлекать различные типы данных, включая текст, изображения и ссылки.

Phantom Buster предоставляет широкий спектр настроек, что позволяет адаптировать его под свои потребности. От выбора источников данных до определения структуры вывода, вы имеете полный контроль над всем процессом сбора информации. Phantom Buster легко интегрируется с различными API, предоставляя дополнительные возможности для обработки данных. Это обеспечивает беспрепятственное взаимодействие с другими платформами, делая его отличным инструментом для веб скрапинга API.

В заключении хочется отметить, что веб-скрапинг и веб-краулинг являются незаменимыми инструментами для осуществления автоматизации при сборе информации. Эти технологии помогают улучшить бизнес-проекты, научные исследования или оптимизировать любую другую область, где требуется обработка и анализ большого количества данных.

Комментарии: 0