Мониторинг поисковой выдачи (SERP) — основа точной SEO-аналитики и планирования бюджета. После изменений в алгоритмах Google привычные подходы к сбору данных стали дороже и медленнее — компаниям нужна техническая база, которая сохранит корректность и устойчивость процессов. В этих условиях прокси для SERP становятся ключевым инструментом для стабильного трекинга позиций и анализа конкурентов.

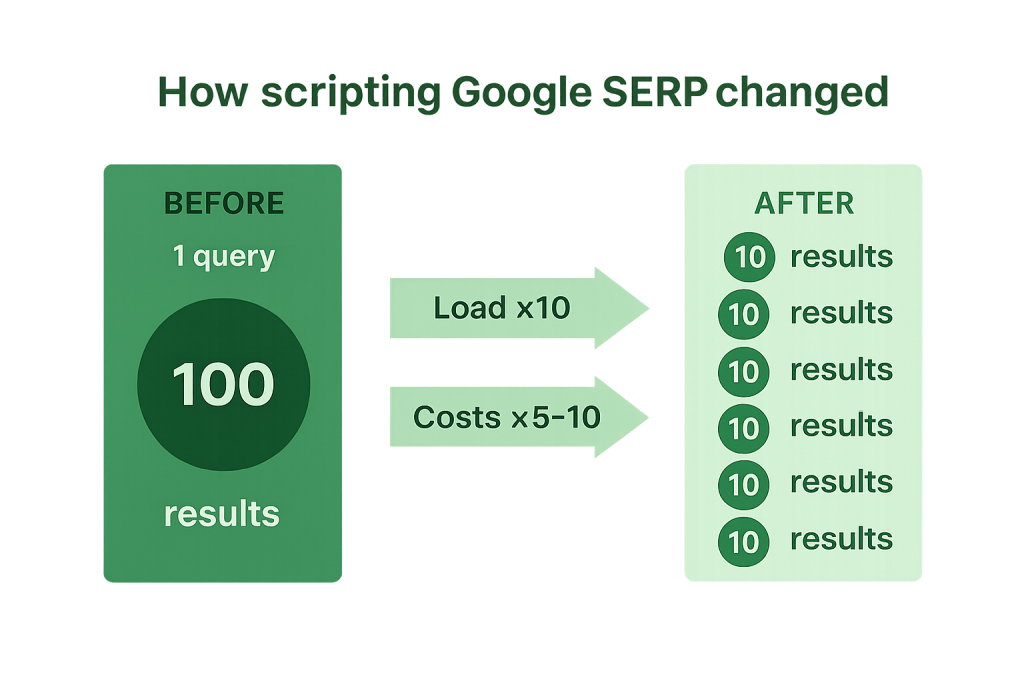

Google отказался от параметра &num=100. Теперь выдача возвращает не более 10 результатов, игнорируя настройки параметра num. Чтобы получить топ-100, необходимо выполнить 10 отдельных запросов. Это ведет к росту обращений, увеличению нагрузки на парсеры, дополнительным расходам на IP-пулы и серверные мощности, а также более сложной организации SERP-мониторинга позиций в корпоративных масштабах.

То, что раньше решалось одним запросом, теперь требует целой цепочки обращений. Для больших агентств, SaaS-платформ и внутренних команд это не просто рост нагрузки — это структурное изменение стоимости данных.

Каждый дополнительный запрос — нагрузка на сеть, увеличение количества IP и дополнительный объем трафика.

Если раньше для анализа 10 000 ключевых слов требовалось 10 000 запросов, то теперь — 100 000. Такая десятикратная разница напрямую влияет на:

Многие SEO-сервисы уже отметили рост затрат на инфраструктуру на 30–50 %, а у компаний, которые используют внешние API для SERP-данных, расходы увеличились в 2–3 раза.

Google стал чувствительнее к массовым обращениям. При высокой частоте запросов с одних и тех же IP появляется риск:

Как следствие, — искаженная аналитика, данные устаревают или дублируются.

Раньше SEO-парсеры работали по принципу “один запрос — один результат”. Сегодня такая архитектура не справляется. Команды переходят к асинхронным и пакетным пайплайнам (batching):

Кроме того, внедряется новая логика приоритизации ключей:

Такой подход позволяет снизить общее количество обращений на 25–40 %, сохранив при этом полноту аналитики.

Ошибки при сборе SERP-информации приводят к искаженным отчетам, а значит — к неверным бизнес-решениям. Когда нагрузка возрастает, стабильность становится важнее скорости.

SEO-платформы теперь оценивают не только точность позиций, но и метрики доступности: процент успешных запросов, время отклика, долю капч и блокировок.

Многие компании создают собственные дашборды качества мониторинга, где отслеживаются показатели:

Это помогает вовремя корректировать частоту и объем запросов, а также оптимизировать пул IP.

Ситуация продемонстрировала, насколько важна инфраструктура прокси: у кого она есть — тот контролирует свои данные.

Фактически, для бизнеса прокси не вспомогательный инструмент, а часть операционной модели SEO-аналитики.

Возможности с прокси:

В крупных агентствах начали выделять отдельные бюджеты на управление IP-инфраструктурой и сервисами прокси — так же, как раньше выделяли бюджеты на контент и ссылки.

| Показатель | До обновления Google | После обновления Google |

|---|---|---|

| Запросов для получения топ-100 по ключу | 1 | 10 |

| Средняя нагрузка на парсер | Низкая | В 5–10 раз выше |

| Устойчивость мониторинга | Стабильная | Зависит от ротации IP |

| Скорость принятия SEO-решений | Выше | Ниже без оптимизаций |

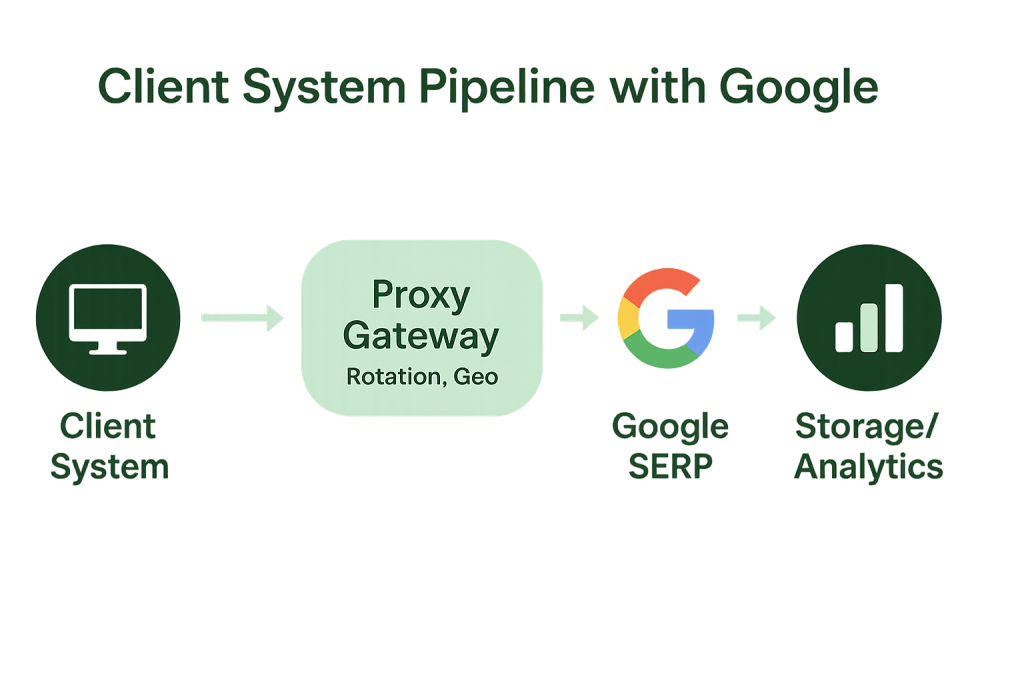

Прокси для мониторинга SERP — управляемый пул IP-адресов (резидентских, мобильных, ISP или дата-центровых), через который SEO-система отправляет запросы к поисковой выдаче. Такая архитектура решает три важных задачи:

Google SERP-прокси — набор IP-адресов и вспомогательных инструментов (шлюз, правила ротации, гео-таргет, лимиты по частоте), оптимизированных для обращения к поисковым системам. Они помогают корректно собирать данные при множественных запросах, соблюдая технические ограничения.

Типы прокси и применимость:

После обновления Google компании начали искать способы оптимизировать мониторинг позиций и сократить возросшие расходы. Главная цель — сохранить точность данных и скорость обработки, не увеличивая бюджет на инфраструктуру. Решения строятся вокруг грамотно выстроенного пайплайна и управляемой прокси-инфраструктуры.

Пайплайн в контексте SEO-мониторинга — технологическая цепочка, через которую проходят все запросы: от постановки задачи и отправки запроса в поисковую систему до получения и анализа данных. Хорошо построенный пайплайн включает в себя:

Это позволяет равномерно распределять нагрузку, получать стабильные результаты и масштабировать процессы без простоев.

Современный подход к работе с SERP можно описать как “управляемый сбор данных”: вместо того чтобы просто отправлять запросы, SEO-команда строит контролируемую систему с аналитикой, автоматикой и метриками. Это снижает нагрузку, повышает точность и делает процесс мониторинга SERP предсказуемым по затратам.

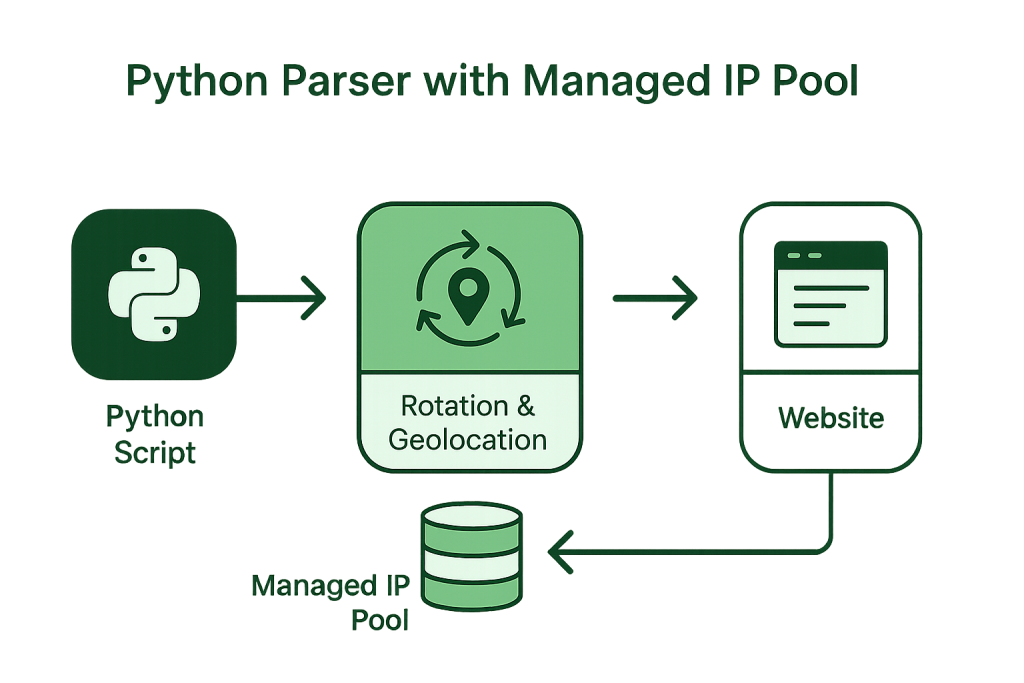

Один из наиболее гибких вариантов — создание самописного парсера на Python, который взаимодействует с SERP через управляемый пул прокси. Такой инструмент позволяет:

На практике такой подход позволяет собрать топ-100 по тысячам запросов без перебоев и блокировок, сохранив предсказуемую нагрузку. Подобные решения подробно описаны в материалах SerpApi Blog — там отмечается, что интеграция Python-парсеров с ротацией IP снижает нагрузку на серверы в 2–3 раза и повышает точность данных до 40%.

Использование прокси стало неотъемлемой частью современных SEO-инструментов. Например, при настройке прокси в GSA Search Engine Ranker можно увидеть, как корректная конфигурация IP-пула помогает автоматизировать трекинг позиций и избежать перебоев в сборе данных. Та же логика применима и к другим системам мониторинга SERP — главное, чтобы соединение оставалось стабильным, а запросы распределялись равномерно между IP.

| Сценарий | Проблема | Решение через прокси и пайплайны |

|---|---|---|

| Массовый SERP-мониторинг по тысячам ключей | Перегрузка и временные ограничения | Пул из 100+ IP, ротация каждые 5–10 мин, батчинг запросов |

| Региональная проверка позиций | Некорректная выдача при одном гео | Резидентские или ISP-прокси с нужными гео и стабильной пропускной способностью |

| SERP и реклама на разных устройствах | Различия с десктопной выдачей | Мобильные прокси, настройка user-agent и таймингов |

| Контроль расходов | Рост стоимости из-за множества запросов | Кэширование, TTL 24–48 ч (количество времени или “прыжков”, в течение которых пакет находится в сети, прежде чем будет отброшен маршрутизатором), модель pay-as-you-go |

| Интеграция с внешними SEO-инструментами | Ограничения частоты API | Прокси-шлюз + адаптивные окна запросов и backoff-механизмы (механизм повторных попыток) |

Многие команды выбирают гибридную модель:

Интеграция таких решений с прокси-провайдерами вроде Proxy-Seller помогает компаниям экономить до 30 % бюджета, сохраняя при этом высокую точность и устойчивость аналитики. Бизнес получает контроль над всеми этапами: от планирования частоты запросов до распределения трафика между IP-пулами и регионами.

Реальные кейсы показывают, как компании и SEO-платформы адаптировались к новым условиям Google SERP и внедрили решения на базе прокси для повышения точности и снижения затрат. В этом разделе рассмотрены примеры из корпоративных B2B-проектов, SEO-сервисов и агентств, которые оптимизировали сбор данных, переработали пайплайны и добились устойчивых результатов.

Исходные данные: 40 000 ключей × 12 регионов × еженедельное обновление топ-100. После изменений Google число обращений выросло на порядок — инфраструктура столкнулась с “узкими местами”: CPU-пики, очереди, рост отказов по таймаутам.

Решение: переход на гибридную модель — часть ключей обслуживается через API (для критически важных кластеров), остальное — собственным скриптом на Python. Введены: пул резидентских прокси по регионам, ротация на уровне 3–5 минут, мягкие окна запросов, повторные попытки с экспоненциальной паузой.

Результат: стабильность пайплайна выросла, отказов стало меньше на 37%, стоимость мониторинга снизилась на 23% за счет кэширования и умных окон.

Исходные данные: продукт ориентирован на мобильный трафик, важен контроль позиций по смартфонам.

Решение: использование динамических прокси, кастомный user-agent-пул, разделение сессий по устройствам, контроль частоты обращений.

Результат: улучшена сопоставимость данных с реальной мобильной выдачей, ускорен цикл обновления отчетов на 28%.

Исходные данные: несколько бизнес-направлений, разные регионы, необходимость быстрой проверочной аналитики топ-10/топ-20.

Решение: комбинация дата-центровых прокси (для экономичных быстрых замеров) и резидентских (для углубленной проверки спорных ключей и региональной точности).

Результат: сокращение времени первичной аналитики в 2,1 раза при сохранении детальности итоговых отчетов.

Правильный выбор поставщика — залог устойчивости и управляемой себестоимости.

Критерии оценки:

Провайдеры уровня Proxy-Seller закрывают эти требования: представляют разные типы прокси, гибкую ротацию, понятные тарифы, удобную панель управления и поддержку распространенных интеграций. Для задач “собрать топ-100 без деградации” это важнее, чем просто максимальная скорость — требуется баланс отклика, стоимости и устойчивости.

Стоимость одного IP-адреса стартует от 1.6$ (IPv4) c возможностью получения индивидуальных условий при приобретении пулов прокси.

Разбивайте ключи на батчи, синхронизируйте окна с ротацией IP, используйте адаптивный троттлинг при всплесках отказов.

Кэшируйте стабильные позиции, обновляйте чаще спорные ключи или те, что “на грани” страниц.

Измеряйте долю успешных ответов, частоту CAPTCHA, среднее время ответа, стабильность ранжирования.

Совмещайте резидентские и мобильные прокси — повышает сходство результатов с реальностью и помогает в рекламном аудите.

Работайте в пределах технических ограничений поисковых систем, корректно настраивайте частоты и интервалы, используйте ретраи (повторные попытки выполнения запроса) с экспоненциальной паузой.

Логи, метрики, дашборды, оповещения — обязательны для корпоративных SLA и расследования инцидентов.

Отказ Google от параметра &num=100 сделал мониторинг поисковой выдачи значительно сложнее. Теперь, чтобы собрать топ-100, требуется больше ресурсов, запросов и грамотная инфраструктура. Компании, использующие надежные прокси для поисковой системы Google, сохраняют стабильность своих SEO-процессов, минимизируют расходы и поддерживают высокую точность аналитики.

Лучшие прокси для SERP — не просто вспомогательный инструмент, а часть стратегического управления данными: они обеспечивают устойчивость парсеров, гибкость процессов и конкурентное преимущество в условиях постоянно меняющихся алгоритмов поисковых систем.

Прокси для SERP — серверы, которые помогают корректно собирать данные из поисковой выдачи Google без перегрузки и временных ограничений. Они позволяют анализировать позиции, получать топ-100 результатов и автоматизировать SEO-мониторинг.

Ориентируйтесь на скорость, стабильность, поддержку ротации и разнообразие гео. Оптимальный вариант — резидентские или мобильные прокси с оплатой по мере использования.

Да, но для масштабных задач рекомендуется использовать пул IP с ротацией, чтобы избежать временных ограничений и повысить точность данных.

Да. Резидентские прокси дают наиболее естественные результаты, так как используют IP-адреса реальных пользователей, что делает их оптимальными для SEO-мониторинга.

Рекомендуется обновлять IP каждые 5–10 минут при интенсивных запросах или использовать автоматическую ротацию, чтобы поддерживать стабильность соединения.

Комментарии: 0