Scrapy — быстрый высокоуровневый фреймворк для парсинга данных, мониторинга цен, анализа поведения пользователей, сбора мнений в социальных сетях, SEO-анализа и других сфер, где нужно исследовать и обрабатывать большие объемы информации из интернета. Он также предлагает встроенные механизмы для управления HTTP-запросами, обработки ошибок и соблюдения правил robots.txt, что делает его эффективным решением для сложных и масштабных проектов по сбору и анализу веб-данных. В этом обзоре будет рассмотрено, что собой представляет Scrapy, как он работает и какие возможности предоставляет пользователям.

Фреймворк Scrapy представляет собой открытое программное обеспечение для запуска веб-скреперов на Python. Он предназначен для автоматического сканирования сайтов (краулинга) и извлечения разнообразных структурированных веб-данных, которые затем могут быть организованы в файлы форматов JSON и CSV или в базы данных, такие как SQLite, MySQL, PostgreSQL и MongoDB. Scrapy может применять различные методы парсинга, включая CSS-селекторы и XPath, а также позволяет работать напрямую с JSON и XML-ответами, что важно при взаимодействии с API.

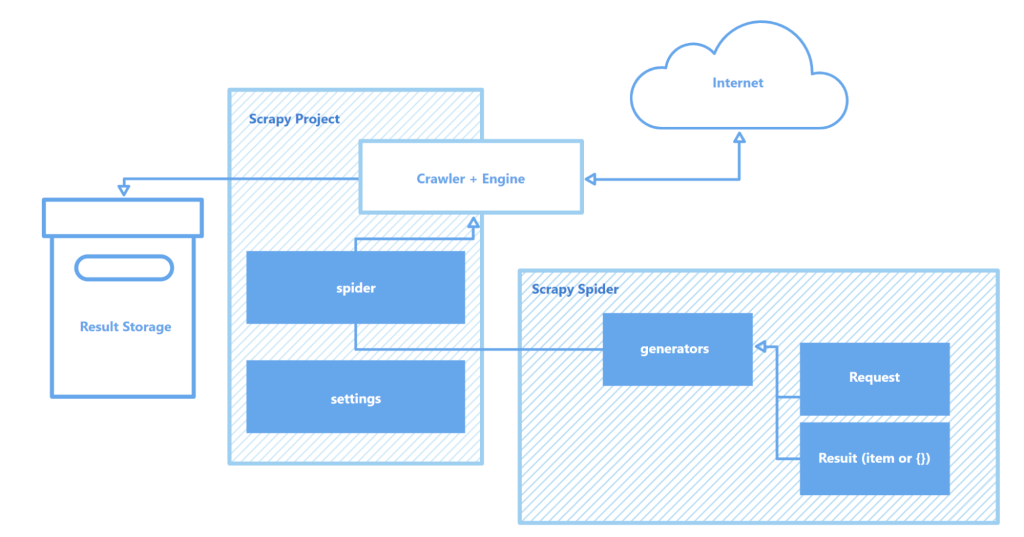

Работа Scrapy основана на использовании «пауков» — краулеров, которые автономно выполняют заданные инструкции по сканированию веб-страниц и сбору данных. Каждый краулер это небольшая программа (скрипт) для поиска объектов определенного типа, такого как текст, изображения или ссылки, и их последующего сохранения. Кроме того, Scrapy предлагает интерактивную оболочку для краулинга, которая позволяет тестировать гипотезы и проверять поведение «паука» в реальном времени. Это значительно ускоряет процесс настройки и оптимизации парсера.

Другие важные компоненты архитектуры фреймворка Scrapy:

Фреймворк Scrapy является одним из самых востребованных инструментов для веб-скрейпинга, предлагая разработчикам мощные и гибкие возможности для эффективного сбора данных из разнообразных источников.

В этом разделе рассматриваются ключевые особенности фреймворка Scrapy, включая скорость сбора и обработки данных, возможности для функционального расширения и портативность. Они выделяют Scrapy среди конкурентов и делают его одним из самых популярных инструментов в области веб-скрейпинга.

Scrapy построен на основе асинхронного сетевого open source-движка Twisted. В синхронном подходе выполнение одной задачи блокирует выполнение следующей до ее завершения, тогда как в асинхронном режиме Twisted возможно параллельное выполнение задач. Это означает, что «пауки» Scrapy могут одновременно отправлять множество запросов и обрабатывать ответы, не дожидаясь ответа и завершения предыдущих операций. Такой подход ускоряет процесс сбора данных и позволяет более эффективно использовать вычислительные ресурсы, что важно при работе над большими проектами и сканировании множества сайтов одновременно.

Скорость работы Scrapy также обеспечивается рядом других факторов:

Сочетание этих возможностей делает Scrapy одним из самых быстрых инструментов для сканирования и сбора данных с множества веб-сайтов. Это особенно важно в таких областях, как анализ цен на товары, парсинг вакансий, мониторинг новостей и социальных сетей, а также при сборе данных для различных исследований.

Scrapy обладает модульной архитектурой, что позволяет легко расширять и адаптировать ее под конкретные задачи. Фреймворк поддерживает интеграцию с различными хранилищами данных, такими как MongoDB, PostgreSQL и Elasticsearch, а также с системами управления очередями, включая Redis и RabbitMQ. Кроме того, библиотеку можно интегрировать с платформами для мониторинга или логирования, такими как Prometheus или Logstash. Это позволяет настраивать и масштабировать скраперы для работы с большими объемами веб-данных и сложными проектами, будь то сбор информации для машинного обучения или разработка поисковых систем.

Функционал каких элементов архитектуры Scrapy можно расширить:

Кроме этого, Scrapy поддерживает создание пользовательских модулей для работы с API, что обеспечивает гибкую настройку и масштабирование решений для обработки больших объемов данных и выполнения сложных проектов.

Еще одним из преимуществ Scrapy является его портативность. Фреймворк поддерживает работу на Windows, macOS и Linux, что делает его удобным для использования в разнообразных средах разработки. Scrapy легко устанавливается через менеджер пакетов Python (pip), а благодаря модульной структуре и гибкости его конфигурации проекты могут переноситься между разными машинами без значительных изменений.

Кроме того, фреймворк поддерживает виртуальные окружения (virtual environments), что позволяет изолировать зависимости проекта и избежать конфликтов с другими установленными пакетами. Это особенно важно при работе над несколькими проектами одновременно или при развертывании приложений на сервере.

Для более удобной работы в Scrapy рекомендуется использовать редактор кода, такой как Visual Studio Code (VS Code) или его аналоги, поскольку взаимодействие с фреймворком осуществляется посредством командной строки (CLI). С ее помощью можно запускать проекты, сканировать сайты, настраивать «пауков» и прочее. Кроме этого, следует использовать виртуальные среды для управления зависимостями. Это позволит избежать конфликтов между библиотеками и версиями пакетов.

Создание и запуск проекта в Scrapy включает несколько шагов.

pip install scrapy

scrapy startproject myproject

myproject/

scrapy.cfg # Настройки проекта

myproject/

__init__.py

items.py # Определение моделей данных

middlewares.py # Промежуточные слои (middlewares)

pipelines.py # Обработка данных

settings.py # Настройки Scrapy

spiders/ # Папка для пауков

__init__.py

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

}

scrapy crawl quotes

Здесь «quotes» — это имя паука, указанное в классе QuotesSpider. Scrapy начнет сканировать указанный URL и извлекать данные согласно настройкам паука.

scrapy crawl quotes -o quotes.json

Scrapy — бесплатный фреймворк для веб-скрапинга, который предлагает разработчикам обширные возможности для автоматизированного извлечения и обработки данных с интернет-страниц. Его асинхронная архитектура и модульная структура обеспечивают высокую скорость работы, отличную масштабируемость и возможность расширения функционала. В то же время интеграция с различными библиотеками и хранилищами данных, а также поддержка кастомных протоколов позволяют легко найти и адаптировать краулер к специфическим требованиям проектов, что делает процесс веб-скрапинга более простым и удобным.

Комментарии: 0