Инструмент для веб-скрапинга — программное обеспечение, предназначенное для автоматизированного извлечения данных с веб-сайтов в структурированном виде. Эти инструменты широко используются для сбора данных, архивации веб-сайтов и аналитики. Продвинутые инструменты предоставляют функции для точного извлечения данных на страницах, предварительного просмотра и их анализа, обеспечивая высокую релевантность и точность собранных данных.

Благодаря своей эффективности и способности к масштабированию, инструменты веб-скрапинга стали незаменимыми в таких областях, как анализ конкурентов, исследование рынка и генерация лидов, обеспечивая компаниям важное конкурентное преимущество.

В этой статье мы рассмотрим лучшие инструменты для веб-скрапинга 2026 года, включая решения для браузеров, фреймворки, библиотеки, API и SaaS скраперы.

При выборе инструмента для веб-скрапинга важно учитывать несколько ключевых аспектов:

Выбор инструмента для веб-скрапинга зависит от уникальных потребностей, включая сложность задачи и объем обрабатываемых данных. Для простых задач зачастую достаточно расширений для браузера, которые легко устанавливаются и не требуют знаний программирования. Фреймворки лучше подходят для разработки более сложных пользовательских решений, требующих глубокой настройки и расширенного функционала. Если же вам нужен полностью управляемый сервис с высоким уровнем автоматизации, стоит рассмотреть API-ориентированные скраперы.

Мы подготовили список из 11 лучших скраперов, в котором представлены как мощные программы для сложных задач веб-скрапинга, так и универсальные инструменты, не требующие знаний в сфере программирования.

Bright Data предоставляет продвинутую платформу для веб-скрапинга, включая Web Scraper IDE с предустановленными шаблонами кода. Эти шаблоны регулярно обновляются, что гарантирует высокую эффективность скрапинга, даже если меняется дизайн целевого сайта.

Bright Data также позволяет использовать прокси с ротацией и предлагает возможности сохранения извлеченных данных в разных форматах, включая JSON и CSV, или напрямую в облачные хранилища, такие как Google Cloud Storage или Amazon S3.

Особенности:

Начальная цена скрапера составляет $4.00 в месяц. Есть бесплатная пробная версия. Рейтинг G2: 4.6/5.0.

Octoparse разработан как для опытных пользователей, так и для новичков, предлагая визуальный метод извлечения данных, который минимизирует или полностью исключает необходимость владения навыками программирования.

Особенностью Octoparse является его ИИ-ассистент, который автоматически распознает шаблоны данных на веб-сайтах и предоставляет рекомендации для оптимизации процесса скрапинга. Кроме того, Octoparse включает библиотеку готовых шаблонов для популярных веб-сайтов, позволяя пользователям быстро начать сбор данных.

Особенности:

Начальная цена скрапера составляет $75.00 в месяц, но также есть возможность использовать бесплатную пробную версию. Рейтинг Capterra: 4.5/5.0. Рейтинг G2: 4.3/5.0.

WebScraper.io — это расширение для Chrome и Firefox, созданное для регулярного и отложенного скрапинга больших объемов данных вручную или автоматически.

Расширение доступно бесплатно для локального использования, а также предлагает платную услугу для планирования и управления задачами скрапинга через API. Этот инструмент поддерживает скрапинг динамических веб-сайтов и сохраняет данные в структурированных форматах, таких как CSV, XLSX или JSON.

Особенности:

Цена скрапера составляет $50 в месяц и включает бесплатную пробную версию. Рейтинг на Capterra составляет 4.7 из 5.

Для начала работы со Scraper API необходимо получить API ключ и указать URL для скрапинга. Scraper API поддерживает рендеринг JavaScript и предлагает полную настройку, позволяя изменять параметры запросов и заголовки в соответствии с вашими задачами.

Особенности:

Форматирование запросов к точкам входа API реализовывается следующим образом:

import requests

payload = {'api_key': 'APIKEY', 'url': 'https://httpbin.org/ip'}

r = requests.get('http://api.scraperapi.com', params=payload)

print(r.text)

Этот скрапер предлагается по начальной цене в $49 в месяц. Рейтинг Capterra составляет 4.6 из 5, а рейтинг G2 — 4.3 из 5.

Scraping Dog выделяется своей простотой и удобством использования, предлагая API для легкой интеграции. Этот инструмент удовлетворяет широкий диапазон потребностей, от базового сбора данных до выполнения сложных операций.

Scraping Dog также поддерживает рендеринг JavaScript, что делает его идеальным для скрапинга сайтов, требующих множественных API-запросов для полной загрузки содержимого.

Особенности:

Вот базовый пример использования API-эндпоинта Scraping Dog:

import requests

url = "https://api.scrapingdog.com/scrape"

params = {

"api_key": "5e5a97e5b1ca5b194f42da86",

"url": "http://httpbin.org/ip",

"dynamic": "false"

}

response = requests.get(url, params=params)

print(response.text)

Скрапер доступен по начальной цене $30 в месяц и предлагает бесплатную пробную версию. Рейтинг на Trustpilot составляет 4.6 из 5.

Apify представляет собой открытую программную платформу, которая облегчает разработку и запуск инструментов для извлечения данных, веб-автоматизации и веб-интеграции. Эта универсальная облачная платформа предлагает полный набор инструментов для веб-скрапинга и автоматизации, и разработана для программистов.

Apify также включает открытую библиотеку для веб-скрапинга под названием Crawlee и поддерживает как Python, так и JavaScript. С помощью Apify вы можете выполнять интеграцию с приложениями сторонних разработчиков, включая Google Drive, GitHub и Slack, а также создавать собственные интеграции через вебхуки и API.

Особенности:

Начальная цена скрапера составляет $49 в месяц и включает бесплатную версию. Рейтинги на Capterra и G2 составляют 4.8 из 5.

ScrapingBee — универсальный API для веб-скрапинга, предназначенный для легкого решения различных задач по извлечению данных из интернета. Он особенно эффективен для выполнения общих задач, таких как скрапинг данных о недвижимости, мониторинг цен и извлечение отзывов, обеспечивая пользователям возможность собирать данные без риска блокировки.

Эта универсальность делает ScrapingBee ценным инструментом для разработчиков, маркетологов и исследователей, стремящихся автоматизировать и упростить процесс сбора данных.

Особенности:

Данный скрапер доступен по начальной цене $49 в месяц и включает бесплатную версию. Рейтинг на Capterra составляет 5.0 из 5.

Diffbot выделяется на фоне других инструментов благодаря своим продвинутым возможностям искусственного интеллекта и машинного обучения, которые делают его особенно эффективным для извлечения контента с веб-страниц. Это полностью автоматизированное решение эффективно справляется с задачами извлечения структурированных данных.

Diffbot идеально подходит для маркетинговых команд и бизнесов, фокусирующихся на генерации лидов и исследовании рынка. Его способность быстро обрабатывать и структурировать данные делает его ценным инструментом для тех, кто нуждается в точном и оперативном извлечении данных без необходимости углубляться в технические нюансы.

Особенности:

Цена скрапера составляет $299 в месяц и включает бесплатную пробную версию. Рейтинг на Capterra составляет 4.5 из 5.

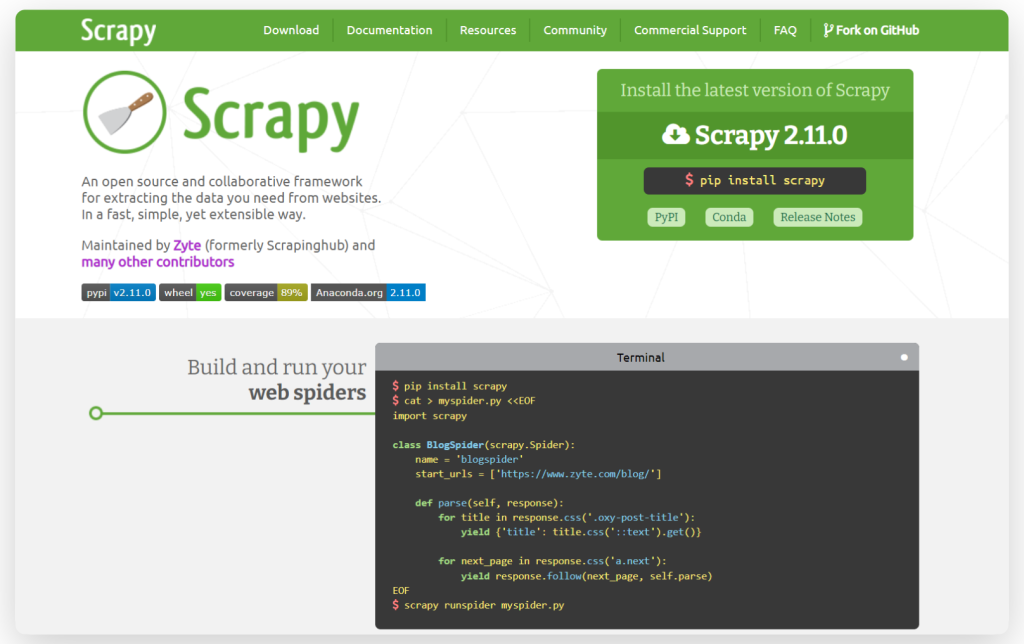

Scrapy — мощный и быстрый открытый фреймворк для веб-краулинга и веб-скрапинга. Scrapy написан на Python и поддерживает работу на таких операционных системах, как Linux, Windows, Mac и BSD. На базе скрапера также есть возможность создавать кастомные поисковые агенты. Также стоит отметить возможность кастомизации составляющих элементов скрапера без необходимости изменять ядро системы.

Особенности:

Вот простой пример использования Scrapy для скрапинга данных с веб-сайта:

import scrapy

class BlogSpider(scrapy.Spider):

name = 'blogspider'

start_urls = ['https://www.zyte.com/blog/']

def parse(self, response):

for title in response.css('.oxy-post-title'):

yield {'title': title.css('::text').get()}

for next_page in response.css('a.next'):

yield response.follow(next_page, self.parse)

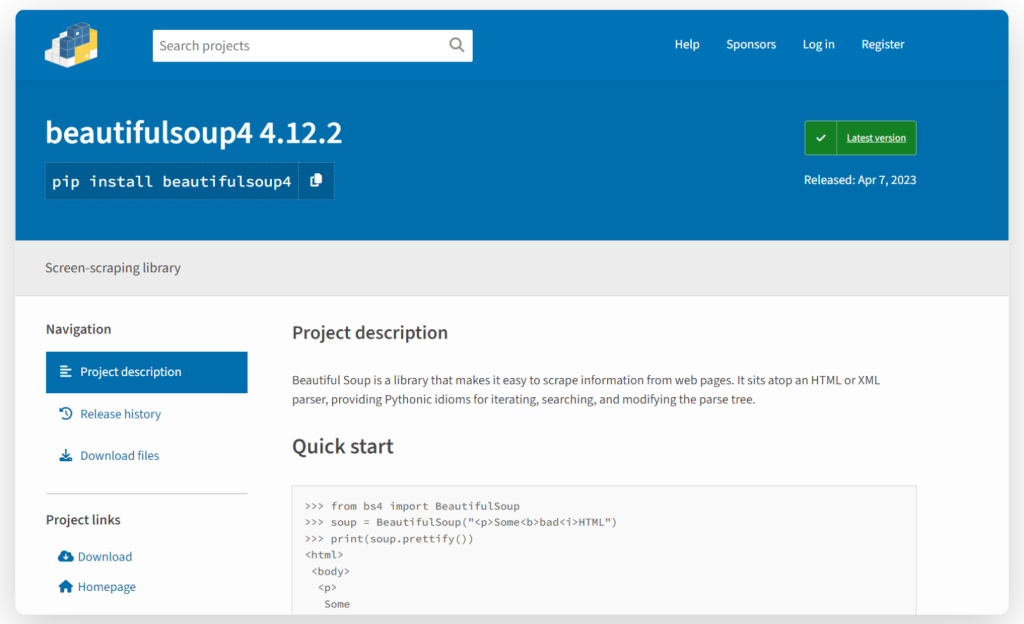

Beautiful Soup — пакет Python для разбора документов HTML и XML, включая те, что имеют некорректную разметку. Он создаёт дерево разбора для документов, которое можно использовать для извлечения данных из HTML, что полезно для веб-скрапинга.

Также стоит отметить, что скарпер не подходит для извлечения динамически генерируемого JavaScript-контента.

Особенности:

Пример использования Beautiful Soup:

from bs4 import BeautifulSoup

html_doc ="""<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

"""

soup = BeautifulSoup(html_doc, 'html.parser')

print(soup.title.string) # Результаты извлечения "The Dormouse's story"

Cheerio — быстрая, гибкая и легкая в использовании библиотека в Node.js, которая реализует основные функции jQuery. Cheerio использует парсер parse5 и может дополнительно использовать толерантный к ошибкам парсер htmlparser2. Также Cheerio может анализировать почти любой документ HTML или XML.

Особенности:

Пример использования Cheerio:

const cheerio = require('cheerio');

// some product webpage

const html = `

<html>

<head>

<title>Sample Page</title>

</head>

<body>

<h1>Welcome to a Product Page</h1>

<div class="products">

<div class="item">Product 1</div>

<div class="item">Product 2</div>

<div class="item">Product 3</div>

</div>

</body>

</html>

`;

const $ = cheerio.load(html);

$('.item').each(function () {

const product = $(this).text();

console.log(product);

});

Как заключение, отметим важные детали, касающиеся каждого из скраперов. К библиотекам для парсинга HTML относятся Cheerio, построенная на основе jQuery для Node.js, и Beautiful Soup — библиотека на Python. Scrapy — фреймворк для веб-скрапинга и парсинга на Python, который поддерживает сложные сценарии и большие объемы данных. Все остальные представленные в подборке скраперы являются платформами или сервисами для веб-скрапинга.

Основываясь на критерии выбора скрапера, можно выделить такие рекомендации:

Комментарии: 0