Для системного сбора данных с веб-сайтов используют веб-скрапинг бот. Это программа, которая автоматически извлекает нужную информацию из страниц. Такое ПО необходимо в ситуациях, когда объем информации слишком велик для ручной обработки или требуется регулярное обновление: например, для мониторинга цен, анализа отзывов, отслеживания позиций в поисковой выдаче.

Бот для веб-скрапинга позволяет автоматизировать такие задачи: он обращается к сайту, получает содержимое страницы, находит нужные фрагменты и сохраняет их в нужном формате. Это стандартный инструмент в e-commerce, SEO, маркетинге и аналитике — там, где скорость и точность обработки данных критичны.

Скрапер-бот — это программный агент, автоматически извлекающий контент с веб-страниц для последующей обработки. Он может быть частью корпоративной системы, работать как независимый скрипт или запускаться через облачную платформу. Его назначение — масштабно собирать структурированные данные, доступные в открытом виде.

Для лучшего понимания вопроса стоит рассмотреть классификацию инструментов, используемых в качестве скрапер-ботов.

По способу доступа к контенту:

По уровню адаптивности к структуре сайтов:

По назначению и архитектуре:

Читайте также: Лучшие инструменты для веб-скрапинга в 2026 году.

Скрапинг-боты применяются в различных отраслях и задачах, где важны скорость, масштаб и структурированность информации.

Каждое из этих направлений требует различной глубины анализа и устойчивости к защите сайтов. Поэтому веб-скрапинг бот адаптируется под задачу — от простых HTTP-скриптов до полноценных браузерных решений с поддержкой прокси и обхода защиты.

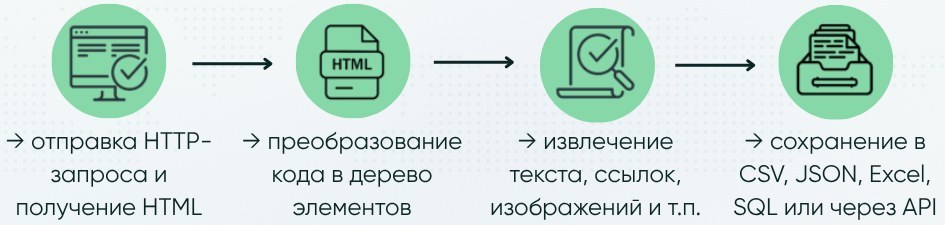

Боты для скрапинга работают по этапному сценарию, где каждый шаг отвечает за конкретное техническое действие. Несмотря на разные библиотеки и языки, базовая логика почти всегда одинакова.

Ниже — более подробное пошаговое описание с примерами на Python.

На первом этапе веб-скрапинг бот инициирует HTTP-запрос к нужному URL и получает HTML-документ. Важно задать корректный заголовок User-Agent, чтобы имитировать поведение обычного браузера.

import requests

headers = {'User-Agent': 'Mozilla/5.0'}

url = 'https://books.toscrape.com/'

response = requests.get(url, headers=headers)

html = response.text

Здесь бот подключается к сайту и получает исходный код страницы, как если бы вы открыли ее в браузере.

Чтобы анализировать содержимое, HTML нужно распарсить — превратить в структуру, с которой удобно работать. Для этого используют библиотеки вроде BeautifulSoup или lxml.

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.prettify()[:1000]) # Отображение первых 1000 строк отформатированного HTML

Теперь HTML можно просматривать как дерево тегов и легко извлекать нужные элементы.

Далее веб-скрапинг бот локализует те фрагменты, которые необходимо извлечь: названия товаров, цены, изображения, ссылки и прочее. Обычно используются CSS-селекторы или XPath.

books = soup.select('.product_pod h3 a')

for book in books:

print(book['title'])

Этот код находит все заголовки книг и выводит их названия.

На этом этапе веб-скрапинг бот «чистит» и структурирует данные: убирает лишние символы, форматирует текст, достает атрибуты (например, href или src) и собирает все в единую таблицу.

data = []

for book in books:

title = book['title']

link = 'https://books.toscrape.com/' + book['href']

data.append({'Название': title, 'Ссылка': link})

Данные превращаются в список словарей, что удобно для дальнейшего анализа.

После извлечения данные сохраняются в нужном формате — CSV, JSON, Excel, базу данных или передаются по API.

import pandas as pd

df = pd.DataFrame(data)

df.to_csv('books.csv', index=False)

Полученные данные удобно анализировать в Excel или загружать в CRM.

Если нужные данные разбросаны по множеству страниц, скрапер-бот реализует обход: переходит по ссылкам и повторяет процесс.

next_page = soup.select_one('li.next a')

if next_page:

next_url = 'https://books.toscrape.com/catalogue/' + next_page['href']

print('Следующая страница:', next_url)

При работе с веб-сайтами, где контент загружается динамически (через JavaScript), используются браузерные движки, например, Selenium или Playwright. Они позволяют боту взаимодействовать с DOM, дожидаться появления нужных элементов и выполнять действия — например, кликать по кнопкам или вводить данные в форму.

DOM (Document Object Model) — это структура веб-страницы, которую браузер формирует из HTML-кода. Она представляет собой дерево, где каждый элемент — заголовок, блок, изображение — это отдельный узел, с которым можно работать программно.

Несмотря на эффективность скрапинга, при взаимодействии с реальными сайтами нередко возникают технические и правовые препятствия.

Для предотвращения автоматизированного доступа внедряются различные системы:

Рекомендуем ознакомиться с материалом, где подробно описано, как производится обработка ReCaptcha и какие инструменты лучше всего подходят для этих целей.

При скрапинге, который сопровождается высокой частотой запросов с одного источника, сервер может:

Для работы в рамках технических ограничений платформ применяются ротационные прокси, распределение трафика через разные IP и настройка пауз между запросами.

Некоторые ресурсы подгружают информацию с помощью JavaScript уже после загрузки HTML или при действиях пользователя, таких как скроллинг.

В таких случаях необходимы браузерные движки — например:

Они позволяют работать с DOM в реальном времени: дожидаться появления элементов, прокручивать страницы, запускать скрипты и извлекать нужную информацию из уже сформированной структуры.

Разработчики сайтов могут изменить:

Такие обновления делают прежнюю логику парсинга неработоспособной или приводят к ошибкам при извлечении.

Чтобы сохранить стабильность, разработчики используют гибкие схемы извлечения, fallback-алгоритмы, надежные селекторы (например, XPath), а также регулярно тестируют и обновляют парсеры.

Автоматический сбор информации может противоречить пользовательскому соглашению. Нарушение этих правил особенно рискованно при коммерческом использовании или распространении собранных данных.

Перед началом скрапинга важно ознакомиться с условиями сервиса. При наличии официального API — его использование предпочтительнее и безопаснее.

Правомерность использования скрапер-ботов зависит от юрисдикции, условий сайта и способа извлечения данных. Важно учитывать три ключевых аспекта:

Подробный разбор юридической стороны читайте в статье о том, законен ли веб-скрапинг.

Создание скрапинг-бота начинается с анализа задачи. Нужно четко понимать, какие данные необходимо извлечь, откуда и с какой регулярностью.

Python — самый популярный язык для веб-скрапинга благодаря готовым библиотекам, лаконичному синтаксису и удобству работы с данными, поэтому мы рассмотрим общий процесс на его примере.

Выбираются библиотеки:

Готовое решение может быть оформлено как CLI-утилита или сервис в облаке. Обязательные компоненты:

Процесс, как создать бот для веб-скрапинга на Python подробно описан в этом материале.

Скрапер-бот как решение для автоматизированного сбора данных позволяет оперативно получать информацию из внешних источников, масштабировать мониторинг и выстраивать аналитические процессы в режиме реального времени. Важно соблюдать технические ограничения платформ, грамотно распределять нагрузку и учитывать правовые аспекты работы с данными.

Мы предоставляем разнообразные прокси для веб-скрапинга. В ассортименте — IPv4, IPv6, ISP, резидентские и мобильные решения.

Для массового сбора с простых сайтов подойдут IPv4. Если требуется стабильность и высокая скорость — используйте ISP-прокси.Для стабильной работы в условиях ограничений по геолокации и технических лимитов платформ рекомендуем резидентские или мобильные прокси: последние обеспечивают максимальную анонимность и устойчивость к ReCaptcha благодаря использованию IP реальных мобильных операторов.

Парсер обрабатывает уже загруженный HTML, а скрапер-бот — самостоятельно загружает страницы, управляет сессиями, повторяет действия пользователя и автоматизирует весь цикл.

Да. Это помогает распределять запросы по различным IP-адресам, что упрощает масштабирование, позволяет собирать данные с множества сайтов параллельно и работать в рамках технических ограничений, установленных платформами.

Рекомендуется использовать ротацию IP, задержки между запросами, корректные заголовки User-Agent и эмуляцию действий пользователя.

Наиболее популярен Python благодаря библиотекам requests, BeautifulSoup, Scrapy, Selenium. Также используются Node.js (Puppeteer), Java (HtmlUnit).

Комментарии: 0