Scraper API — это инструмент для скрапинга (извлечения данных с веб-сайтов). Он позволяет пользователям со всего мира получать доступ к данным веб-сайтов, обходя блокировки и ограничения. Сегодня сервис может повысить эффективность и анонимность ваших запросов, сделав этот процесс беспрепятственным. В этой статье мы подробно расскажем, как настроить прокси в Scraper API, чтобы вы могли использовать его без сложностей и ограничений.

Если использовать прокси в Scraper API, это позволит эффективно извлекать данные с веб-сайтов, обходя блокировки и ограничения. Следуйте этой пошаговой инструкции, чтобы успешно настроить прокси в Scraper API и получить нужные данные с веб-сайтов:

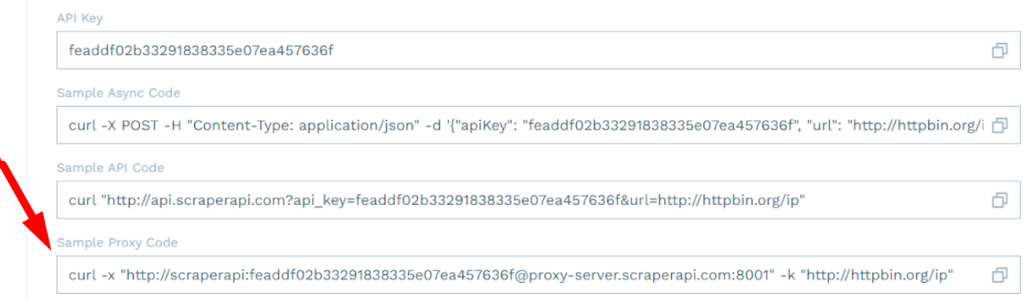

Для использования прокси-серверов в Scraper API в этом коде нужно заменить данные на новые. Прокси-серверы Scraper API поддерживают HTTP, HTTPS и SOCKS5 прокси.

После «-k» нужно указать страницу, с которой будет производиться скрапинг данных с использованием прокси.

С помощью этой команды вы сможете создавать запросы на разных языках программирования. Например, для Node JS код будет выглядеть так:

proxy: {

host: 'ваш новый айпи-адрес',

port: номер порта,

auth: {

username: 'ваш логин',

password: 'ваш пароль'

},

protocol: 'http'

}

Для Python код интеграции прокси с протоколом HTTP выглядит так:

import requests

proxies = {

"http": "http://ваш логин:ваш пароль@ваш айпи-адрес:номер порта"

}

Таким образом можно задать несколько прокси, дублируя нужный участок кода. Это позволит использовать Scraper API с минимальным риском блокировки по IP и даст возможность собирать данные с тех ресурсов, которые заблокированы по гео.

Комментарии: 0